Ci accoglie una Londra surreale, siamo nel pieno dei 10 giorni di lutto nazionale previsti dalla Corona. Un pensiero in memoria della Regina Elisabetta II accompagna chiunque arrivi in città, qualunque strada si percorra, qualsiasi appuntamento si abbia in programma.

“All of us at ReWork would like to pass on our deepest condolences to an extraordinary life.” L’evento viene confermato: con questo messaggio in omaggio alla regina, l’organizzazione di ReWork si prepara ad accoglierci all’AI Summit. Un’occasione unica per confrontarsi con i principali professionisti e ricercatori del settore, un appuntamento importante per esplorare interessanti casi di studio nel campo dell’intelligenza artificiale e delle interfacce conversazionali. Oltre ai preziosi momenti dedicati al networking, l’evento prevede tre diverse track: Deep Learning, AI in Retail e Conversational AI, una variegata commistione di talk che io, Pietro e Giuseppe abbiamo avuto modo di seguire dai tre rispettivi stage preparati all’interno dell’Etc.Venue al n° 133 di Houndsditch.

Eccoci, dunque, a condensare i preziosi spunti che ciascuno di noi ha raccolto durante l’evento delle scorse settimane. Di ritorno da questa esperienza di formazione, condividere ciò che più ci ha entusiasmati ci permette di ragionare su spunti concreti da mettere in pratica: le tante opportunità che offre questa interessante area dell’IT e del digital è sicuramente un terreno fertile per coltivare nuove strategie, orientate alla crescita dei nostri clienti.

Deep Learning Summit

La traccia relativa al Deep Learning è stata veramente stimolante, carica di contenuti e nozioni teoriche interessanti.

Con queste premesse Pietro ci introduce ai talk più tecnici del Deep Learning Summit. Lasciamo a lui la parola e scopriamo gli aspetti più significativi di queste giornate di formazione.

«Impossibile non partire con delle nozioni relative ai modelli fisici e matematici sui quali si basano tutti i concetti relativi all’Intelligenza Artificiale e al Deep Learning: questo compito è stato lasciato a Michael Bronstein, professore di Intelligenza Artificiale all’università di Oxford. A seguito della sua introduzione, sul palco si sono alternati molti relatori, ognuno dei quali ha portato tematiche ed esperienze differenti.

Tra le più interessanti, includo il talk di Edward Johns, direttore del laboratorio di robotica dell’Imperial college di Londra e partner di Dyson. Johns è fortemente convinto di una cosa.

L’IA porterà forti cambiamenti al mondo della robotica e, attraverso il Deep Learning, i robot possono imparare ad eseguire i loro task attraverso le dimostrazioni umane.

L’approccio è fortemente cambiato rispetto alla programmazione classica che veniva fatta sui vari tipi di robot. Attraverso l’Imitation Learning, infatti, dopo aver costruito un modello matematico valido che rappresenti il caso in questione ed aver dato in pasto ai robot una quantità sufficiente di dati è possibile, tramite l’interazione uomo-robot, che questi imparino ad eseguire determinate task. L’apprendimento può essere fatto sia per accompagnamento (se il robot è costituito da un braccio questo può essere accompagnato manualmente durante l’esecuzione del task) oppure tramite riconoscimento. In entrambi i casi è stato dimostrato che questa metodologia porta dei risultati in modo più preciso e con una velocità molto maggiore rispetto ai metodi utilizzati precedentemente.

Un’altra esperienza significativa è stata quella di Zhenwen Dai, ricercatore a Spotify.

Ci ha mostrato come vengono usate le tecniche di Reinforcement Learning per personalizzare l’esperienza di ascolto che hanno gli utenti quando utilizzano il servizio delle interactive radio.

Durante le sessioni di ascolto l’agente aggiorna la scaletta della stazione radio in base al feedback dato dall’utente (quindi se ascolta tutta la canzone oppure se la salta passando così alla successiva). Questo meccanismo è assai diverso dai paradigmi classici fatti per raccomandazione. Inoltre, sempre attraverso questi modelli, sulla base delle preferenze dell’utente, sono in grado di proporre delle playlist formate da canzoni che potrebbero diventare delle potenziali preferite: l’ascoltatore infatti non conosce queste tracce ma, in base agli ascolti fatti e ai suoi comportamenti, il team di Spotify è confidente che queste potrebbero essere delle potenziali desiderate. I risultati degli esperimenti sono stati soddisfacenti e, al momento, crede che continueranno ad investire in quella strada.

Un altro campo di forte applicazione dell’Intelligenza Artificiale è quello relativo all’entertainement sportivo, sul quale Huma Lodhi, la Lead Machine Learning Engineer a Sky, ci ha aperto scenari interessanti.

L’IA è ormai un supporto costante nelle loro trasmissioni di eventi sportivi. In aula ha riportato la casistica relativa al calcio ma ci ha assicurato che, anche negli altri sport, l’utilizzo è altissimo.

Per quanto riguarda il calcio, a causa della diversità degli stili di gioco dei vari campionati, il team di Sky ha dovuto creare un modello differente per ogni lega, in modo da fornire un supporto più calzante possibile alle loro attività. L’IA nel corso di una partita ha diverse applicazioni, che possono essere distinte in 3 fasi.

Nella prima fase, in ogni istante, vengono rilevate le coordinate di ogni giocatore, del pallone e della porta e, basandosi sulle posizioni e sui modelli in loro possesso, hanno la possibilità di calcolare la probabilità che succedano delle “azioni interessanti”, dei goal, o tentativi di tiro a rete ed attivare così la camera corrispondente.

Nella seconda fase, quando viene fatto il primo piano di un giocatore sono in grado di riconoscerlo tramite la maglietta che indossa e proporre così delle informazioni riassuntive sulle sue performance da mandare in combinata con i segnali video e audio.

Infine, per quanto riguarda l’ultima fase, nel calcolo del fuorigioco effettuano delle proiezioni sul campo delle parti del corpo dei giocatori e, in base allo svolgimento dell’azione (tenendo conto anche di quelle “singolarità” dovute ai giocatori che non sono interessati al momento) riescono a determinare se una proiezione è oltre quella di riferimento per la soglia del fuorigioco.Toju Duke, program manager della Responsible Ai a Google ci ha parlato delle sfide che devono sostenere in termini di etica e di responsabilità.

Se i sistemi di intelligenza artificiale e machine learning non vengono sviluppati senza un occhio etico e responsabile, potrebbero infatti distribuire danni tra gli individui.

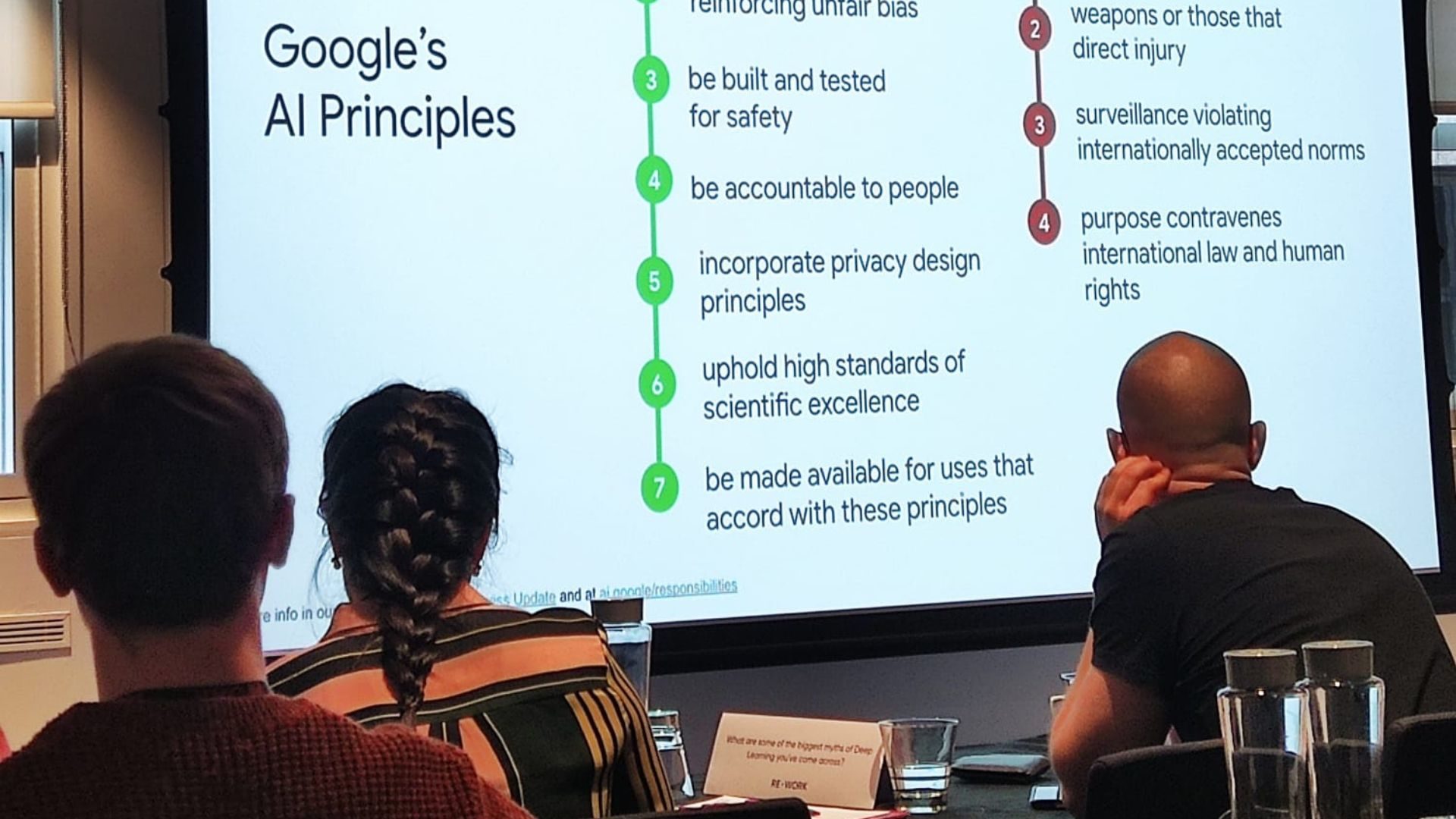

Ogni organizzazione che li sviluppa dovrebbe avere infatti un quadro di responsabilità a cui aderire che sia equo, trasparente e sicuro. A Google usano un sistema human-centered: il modo in cui gli utenti reali sperimentano il sistema è infatti essenziale per valutarne il vero impatto sulle sue previsioni, raccomandazioni e decisioni. Qualora vengano trovati danni potenziali nei modelli in questione si provvede subito ad effettuare dei test antagonisti in modo da capire dove il modello potrebbe fallire e, a seguito di una fase iterativa di test e misurazioni, si sviluppa un’attenuazione dell’AI per i conflitti identificati. In definitiva, a Google credono che le loro applicazioni di IA debbano evitare di creare o rafforzare pregiudizi ingiusti, incorporare i principi di progettazione della privacy, mantenere elevati standard di eccellenza scientifica, limitare le applicazioni potenzialmente dannose e/o abusive; in più dovrebbero essere socialmente utili, costruite e testate per la sicurezza, responsabili nei confronti delle persone».

AI in Retail Summit

Vediamo, invece, cosa ci racconta Giuseppe che ha avuto modo di seguire i talk relativi all’AI in Retail Summit, la macroarea dell’evento dedicata agli ultimi progressi dell’intelligenza artificiale applicati all’utilizzo di metodi per migliorare il servizio clienti e le iniziative di marketing. Ecco le sue considerazioni.

«L’evento si apre con alcune speculazioni sul Machine Learning. Questa branca dell’intelligenza artificiale ha lo scopo di creare sistemi in grado di apprendere e migliorare le performance in base ai dati forniti. È esattamente ciò che ogni agenzia digital ha la necessità di compiere ogni giorno, continuando ad analizzare tonnellate di dati e investendo tempo considerevole; il rischio è che spesso le considerazioni estrapolate a seguito dell’analisi non siano effettivamente corrette, a causa di una cattiva manipolazione o incompleta raccolta di dati. Questo è stato il punto di partenza della discussione, a cui ha fatto seguito la presentazione di diversi progetti mirati alla risoluzione delle problematiche citate, ciascuno con il proprio focus operativo specifico.

Tra i diversi talk, ho avuto modo di individuarne alcuni che hanno suscitato un mio forte interesse.

Nel talk, pilotato dal gruppo Data Analyst di BlaBlaCar, ci è stata presentata la realizzazione di un modello di attribuzione Multi-Touch basato sull’algoritmo di Markov.

Nel marketing i modelli di attribuzione vengono utilizzati per assegnare le conversioni ai differenti canali (organico, a pagamento, social, referral) e quindi ci permettono di monitorare le performance sugli investimenti di ognuno di questi. I modelli di attribuzione più comuni e più utilizzati anche dalla maggior parte delle piattaforme sono: ultimo clic, primo clic o in base alla posizione. Un calcolo delle performance così semplicistico spesso non rispecchia esattamente la realtà e non ci permette di capire quanto un canale che non abbia convertito come “ultimo clic” sia fondamentale in una strategia di marketing.

Nicolas Peltre, Ken Morange e il resto del team BlaBlaCar, grazie all’utilizzo dell’algoritmo di Markov, sono riusciti ad assegnare un valore ad ogni touch-point e, sulla base di questo dato, ad incrementare le performance delle campagne di marketing.

Altro tema fondamentale nella gestione degli eCommerce è quello di riuscire a proporre un prodotto, il più simile possibile a quello ricercato dall’utente, nel caso in cui non dovesse risultare in stock.

Il Case study ci è stato fornito da Florentin Kristen e dal team di Chrono24, eCommerce che possiede il più grande inventario di orologi di lusso al mondo che comprende oltre 10 milioni di orologi. Molti dei prodotti presenti su Chrono24 sono edizioni limitate o in altro modo unici. Durante l’intervento ci hanno spiegato come sono riusciti ad utilizzare tutti i dati relativi agli orologi raccolti nel tempo, comprendenti un grandissimo numero di caratteristiche, per costruire un modello di embedding basato sugli attributi, ed utilizzando tecniche di elaborazione del linguaggio naturale (NLP). Il risultato mostrato è stato a dir poco sorprendente, i prodotti che venivano suggeriti erano molto vicini al prodotto di partenza».

Conversational AI Summit

Sul palco dedicato alle interfacce conversazionali si parla degli ultimi progressi tecnologici in ambito NLP e di applicazioni dell’IA conversazionale. I momenti conclusivi di ciascun talk, dedicati alle domande, sono stati i più preziosi per cogliere ciò che crea più grattacapi a chi sviluppa agenti conversazionali e quindi per far emergere, nel concreto, quali sono ad oggi gli aspetti più limitanti. Ecco i temi più interessanti e i protagonisti di alcuni progetti presentati.

Pensare a livello locale, agire a livello globale

L’ambiziosa iniziativa di Bosch Rexroth richiede il coordinamento tra più Paesi, ciascuno con i propri requisiti specifici: Chatbots@DC ha l’obiettivo di decentralizzare i bot in diverse nazioni per garantire maggiore efficienza ed esperienze più impattanti e positive a livello globale. Nel loro speech, Özge Karadag e Oliver Maus ci raccontano cosa è fondamentale tenere in considerazione quando si tratta di sviluppare parallelamente diversi chatbot, sulla base della loro esperienza in partnership con Cognigy.

Da questo talk risulta evidente quanto la Content Localization giochi uno dei ruoli più importanti nel conversazionale.

È risultata fondamentale proprio l’esperienza con Cognigy, il cui tool di data retrieving ha permesso di raccogliere in modo rapido e capillare i dati utili a costruire un dizionario e mappare altri contenuti. Per quanto riguarda le modalità di lettura del dato, Bosch Rexrot ha realizzato una dashboard con Power BI per integrare i dati da Cognigy, riadattandola a seconda delle diverse country dei bot; in più, viene integrata con una heatmap legata agli orari di maggior utilizzo dei chatbot. Emerge infine la particolare attenzione che Bosch Rexrot riserva al tema della coerenza: il team di sviluppo di un bot rimane lo stesso, dall’inizio alla fine del processo e segue costantemente precise guideline. Come è chiaro, il livello di questi bot è notevole; ciò che l’azienda si riserva per il futuro è un lavoro sempre più approfondito in materia di sentiment analysis sui testi raccolti attraverso questo sistema capillare.

La “famiglia allargata” di E.ON

Notevole è anche il contributo di Karyna Tubolyeva, Conversational Experience Expert ad E.ON, che ci introduce il concetto di “Master Bot”, a cui il suo team è arrivato dopo un percorso di diversi anni nell’automazione dei processi di customer support: si parte dalla live chat del 2015, passando per lo sviluppo di un FAQ bot nel 2017, arrivando al più evoluto IVR Voice bot del 2021. Il Master bot di E.ON e la cosiddetta Family bot vedono infine la luce nel 2022, grazie ad un lavoro portato avanti in partnership con Cognigy. Il Parent bot designato a prima interfaccia per l’utente, gestisce numerosi Child bot, a cui è possibile essere indirizzati, ciascuno con la propria personalità oltre che la propria conoscenza.

Quanto contano i Knowledge Gap?

Sono interessanti, inoltre, gli studi presentati per colmare i knowledge gap nei sistemi conversazionali di intelligenza artificiale: una sfida fondamentale per garantire sempre maggiore precisione e conversazioni realistiche. Questi temi vengono affrontati da Dhaval Thakker, Professore di AI & IOT alla University of Hull, che propone diverse soluzioni basate su una ricerca condotta nell’ambito di un progetto finanziato da Innovate UK per la costruzione di un sistema di conversational AI a sostegno in materia di immigrazione nel Regno Unito.

Il caso presentato è emblematico perchè si tratta di un settore per cui la conoscenza di base è spesso soggetta a modifiche.

Queste sono dovute ai cambiamenti delle norme sull’immigrazione e, come questo, esistono diversi settori caratterizzati da questo dinamismo (pensiamo ad esempio alla consulenza legale, finanziaria e a quella medica).

Le proposte di Dhaval Thakker tengono in considerazione i knowledge graph, valutando tool utili per lavorare in questa direzione (Gate NLP sembra essere interessante) e proponendo question template come Jape Transducer per una visione completa dell’intera architettura.

Superhuman Conversational AI, il talk targato Google

Con Yariv Adan, Product Lead di Google, veniamo portati a riflettere sugli alti livelli che l’intelligenza artificiale ha raggiunto in diversi ambiti e a chiederci se anche nel conversazionale possiamo dire di essere finalmente di fronte a dei bot che superano capacità e conoscenze di un umano. Gli spunti della conversazione si rifanno ad alcuni dei recenti sviluppi direttamente da Google Cloud AI, Google Brain Research, Deepmind, e Duplex; con Yariv restiamo piacevolmente coinvolti da alcuni esempi di applicazione basati sul riconoscimento vocale, la generazione e la comprensione del linguaggio naturale.

Escludendo però le particolari eccellenze riportate nel talk di Yariv, la realtà che emerge nel corso dell’evento è che l’intelligenza artificiale nell’ambito del conversazionale ha ancora molta strada da percorrere.

Sfide e soluzioni odierne nella creazione di assistenti virtuali

Sebbene attualmente vengano utilizzati soprattutto per compiti relativamente semplici e task one-shot, è chiaro che le applicazioni potenziali degli assistenti conversazionali sono molto più ampie. Per realizzare questo potenziale, è necessario compiere progressi significativi nel campo del Conversational AI.

Ciò a cui ci troviamo di fronte è lo sviluppo di sempre più modelli linguistici e dataset, con l’intento di permettere a questi sistemi di intraprendere conversazioni più naturali con gli utenti.

Durante questo speech abbiamo esplorato insieme a Michael McTear, Professore Emerito alla Ulster University, gli avanzamenti che contribuiranno a realizzarne il pieno potenziale.

Facendo una panoramica, le attuali tecnologie comprendono: follow-up queries, ovvero un convesazionale basato su Q&A (sistemi di dialogo, il cui monitoraggio delle entità nel contesto lavora come Contextual Slot Carryover); task completion, ovvero una slot-filling task in cui il sistema identifica diversi frame in corrispondenza di una finestra di dialogo in esecuzione. Questi frame rappresentano diversi parametri della query dell’utente (es. “Prenotami un volo”).

Le tecnologie in evoluzione riguardano invece i dialoghi multi-turn Open-Domain, legati ad un user input arbitrario e capaci di mantenere il contesto e risposte pertinent (es. Xiaoice).

L’approccio tradizionale si rifà, infine, ai dialoghi “disegnati su misura” tramite flow map. Il limite di questo approccio va ricercato nel fatto che risulta molto difficile avere ben chiari fin dall’inizio quali siano gli happy path, ed è ancora più difficile porvi rimedio dopo aver testato il sistema. Un’alternativa a ciò sono i Neural Dialogue, ovvero un sistema deep learning conversazionale, che ha però ancora i suoi limiti riguardanti la grande quantità di dati necessari come risorse e come training, oppure nel fornire risposte controllate o fatti non corretti.

Alla luce di tutto ciò, possiamo dire che il Deep Learning rimane l’aspetto preminente da approfondire e da migliorare: ciò su cui si dovrà lavorare è il Deep Reinforcement Learning, senza dimenticare di dare il giusto peso a UX e user involvment.

L’AI Summit di Londra è stata sicuramente un’occasione formativa unica e, al di là della semplice partecipazione alla conferenza, ci ha permesso di confrontarci con diverse realtà della scena internazionale, professionisti e potenziali partner, insieme ai quali poter dare il via a collaborazioni strategiche per diversi progetti della nostra agenzia.